Recuperación Contextual en Anthropic con Bases de Conocimiento de Amazon Bedrock

En la búsqueda de mejorar la efectividad de los modelos de inteligencia artificial (IA) en dominios especializados, la incorporación de […]

En la búsqueda de mejorar la efectividad de los modelos de inteligencia artificial (IA) en dominios especializados, la incorporación de conocimiento relevante es esencial. Por ejemplo, un asistente virtual de atención al cliente requiere información detallada sobre la empresa a la que sirve, mientras que una herramienta de análisis legal debe acceder a una base de datos integral de casos pasados. Para lograr esto, los desarrolladores utilizan a menudo la técnica de Generación Aumentada por Recuperación (RAG), que permite obtener información pertinente de una base de conocimiento y la integra en la solicitud del usuario, mejorando significativamente las respuestas del modelo. Sin embargo, las limitaciones de los sistemas RAG tradicionales se hacen evidentes al perder matices contextuales durante la codificación de datos, lo que puede resultar en recuperaciones irrelevantes o incompletas.

En los sistemas RAG convencionales, los documentos se dividen en fragmentos más pequeños para optimizar la eficiencia de recuperación. Aunque esta metodología resulta efectiva en muchos casos, puede generar problemas si cada fragmento carece del contexto necesario. Por ejemplo, en una política que exige «seis meses de antigüedad» para el trabajo remoto, pero omite la parte que vincula excepciones a la aprobación del gerente, un usuario que pregunte sobre la elegibilidad de un empleado con tres meses de antigüedad podría recibir una respuesta errónea. Para abordar esta limitación, el enfoque de recuperación contextual enriquece la representación vectorial con información contextual relevante, permitiendo respuestas más precisas y matizadas.

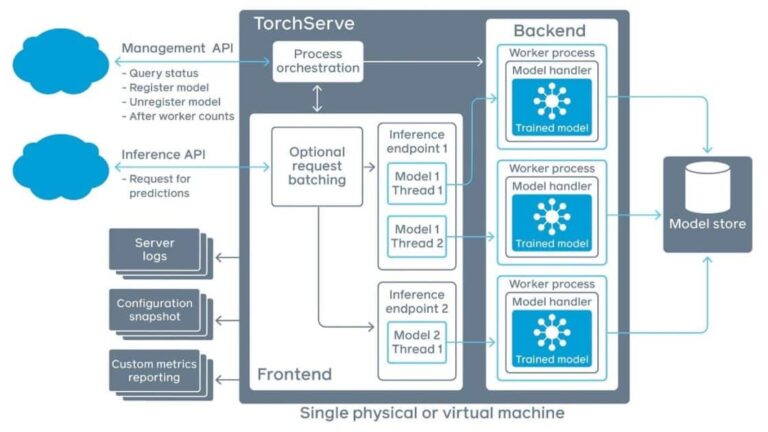

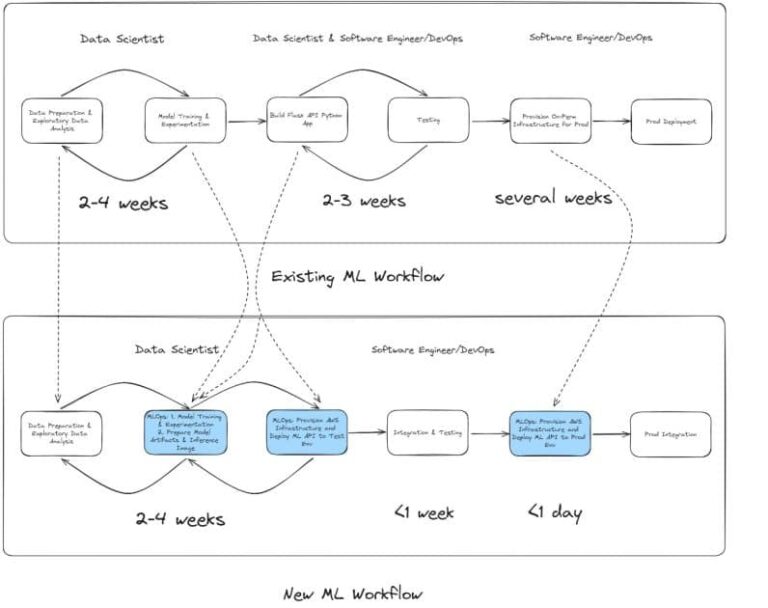

Un reciente estudio demuestra la integración de este enfoque con las bases de conocimiento de Amazon Bedrock y el modelo Claude de Anthropic. Utilizando una función Lambda personalizada durante el proceso de ingesta de datos, los documentos se procesan en fragmentos, pero ahora cada uno es complementado con información contextual antes de ser almacenados en un bucket de S3 intermedio.

La implementación de la recuperación contextual se realiza en varios pasos. Primero, es necesario leer los archivos desde un bucket designado, dividir la información en fragmentos, generar información contextual con Claude, y luego guardar los fragmentos procesados en el bucket intermedio. La arquitectura del sistema permite el manejo eficiente de documentos largos, optimizando la calidad de las respuestas.

Para evaluar este nuevo método comparado con el enfoque de fragmentación por defecto, se usaron métricas como el recall de contexto y la precisión de respuesta. Los resultados mostraron que el enfoque de recuperación contextual superó al tradicional en la calidad de las respuestas generadas, reflejando la efectividad de técnicas más sofisticadas en la mejora de sistemas de IA.

Sin embargo, existen diversas consideraciones para implementar esta solución. La estrategia de fragmentación debe ser optimizada para balancear rendimiento y precisión, y el monitoreo de métricas clave es vital para asegurar la efectividad del sistema. Usar herramientas de observabilidad, como Langfuse, puede permitir una mejor gestión del rendimiento.

Finalmente, la combinación de los modelos de lenguaje de Anthropic con la infraestructura de Amazon Bedrock permite a las organizaciones desarrollar sistemas inteligentes de recuperación de información, proporcionando respuestas contextualizadas y matizadas. Con los pasos de implementación claramente delineados, las empresas están en una posición fuerte para aprovechar el potencial completo de los sistemas de IA con conciencia del contexto.

.jfif)